|

| Công cụ AI được các hãng công nghệ sử dụng để bảo vệ người dùng trên không gian mạng - Ảnh: The Gurdian |

Lâu nay, công cụ sử dụng thuật toán trí tuệ nhân tạo (AI) được phát triển bởi một số “ông lớn” công nghệ như Google và Microsoft được cho là có nhiệm vụ bảo vệ người dùng.

Theo đó, việc xác định hình ảnh đăng trên mạng xã hội có bị “dính” hành vi bạo lực hoặc khiêu dâm hay không có thể giúp ngăn chặn kịp thời trước khi chúng xuất hiện trước mắt mọi người.

Các tập đoàn công nghệ này còn tuyên bố rằng, công cụ AI của họ còn có thể phát hiện “tình trạng phân biệt chủng tộc” hoặc mức độ khêu gợi tình dục của một hình ảnh được đăng lên mạng xã hội như Instagram và LinkedIn.

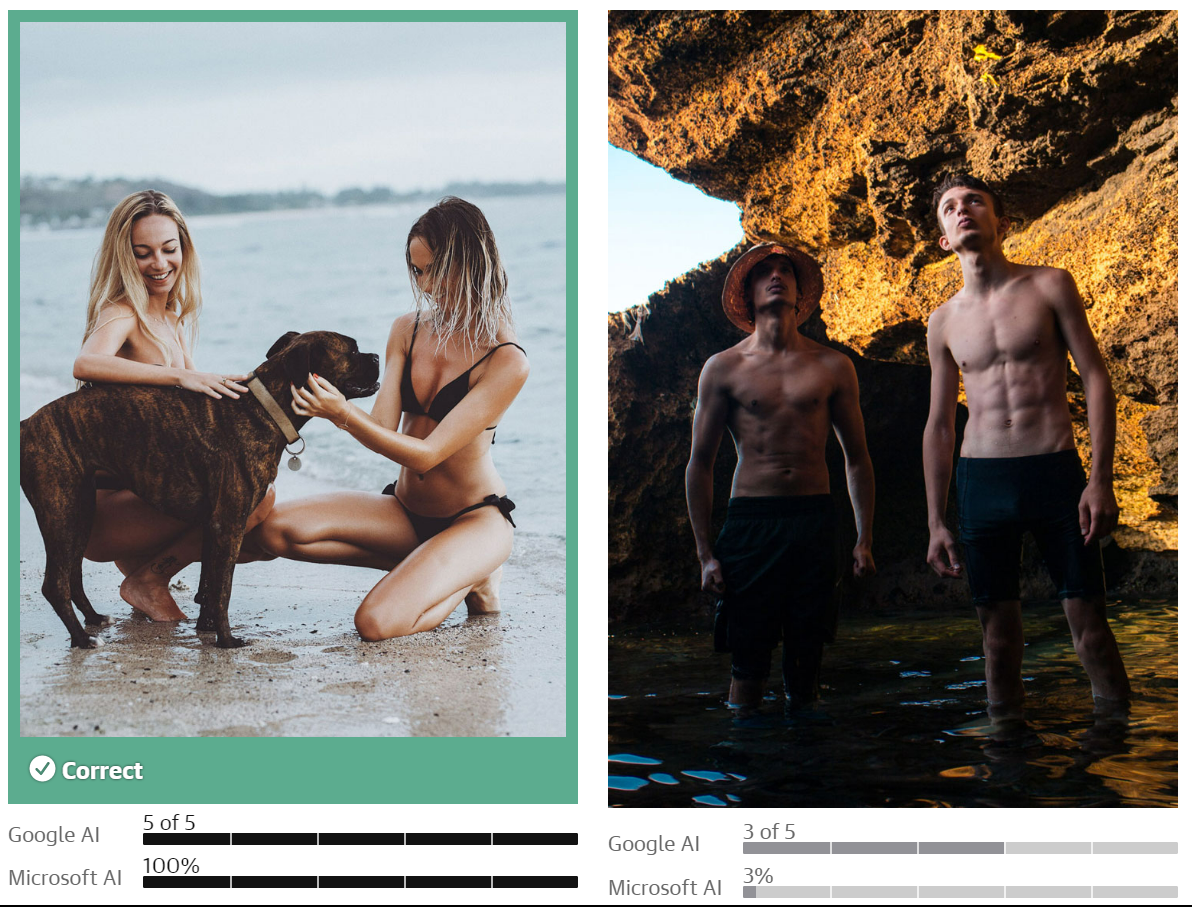

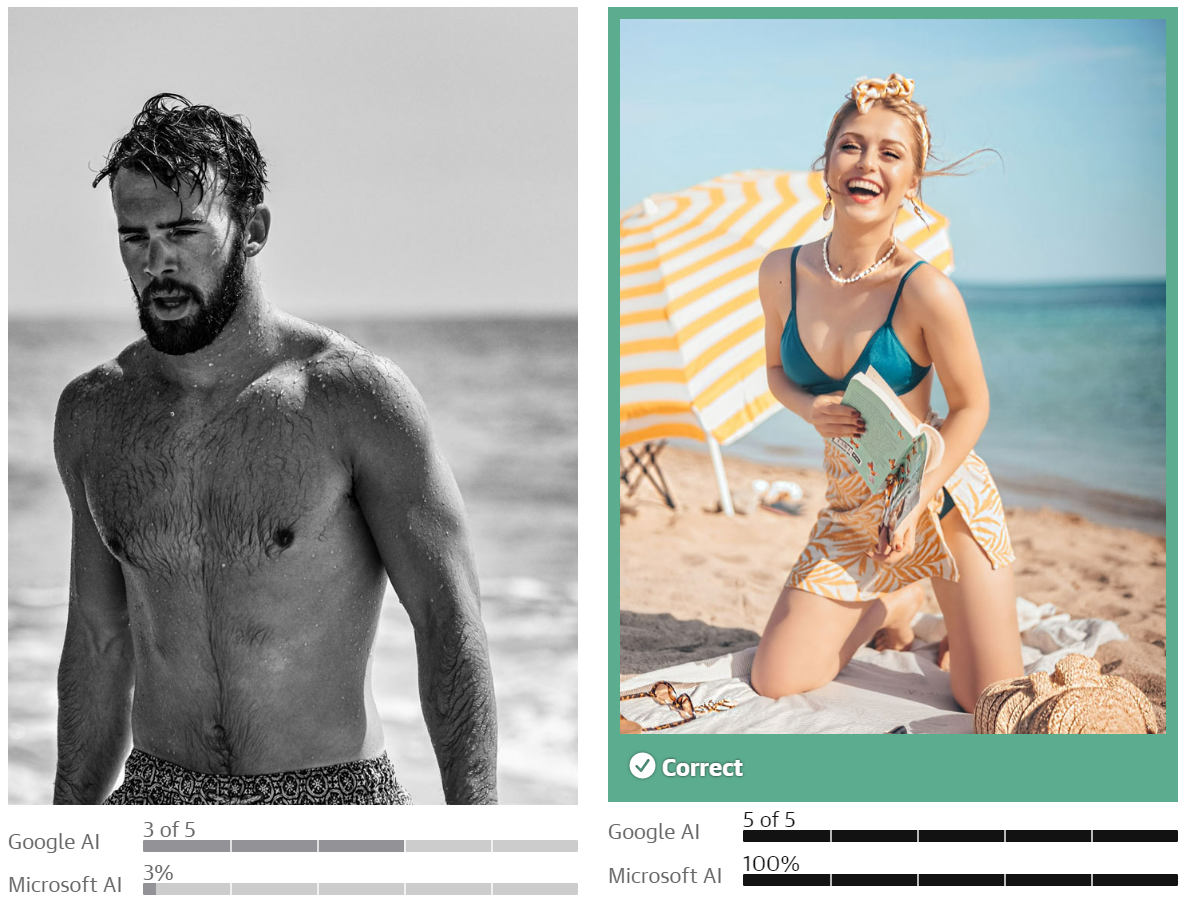

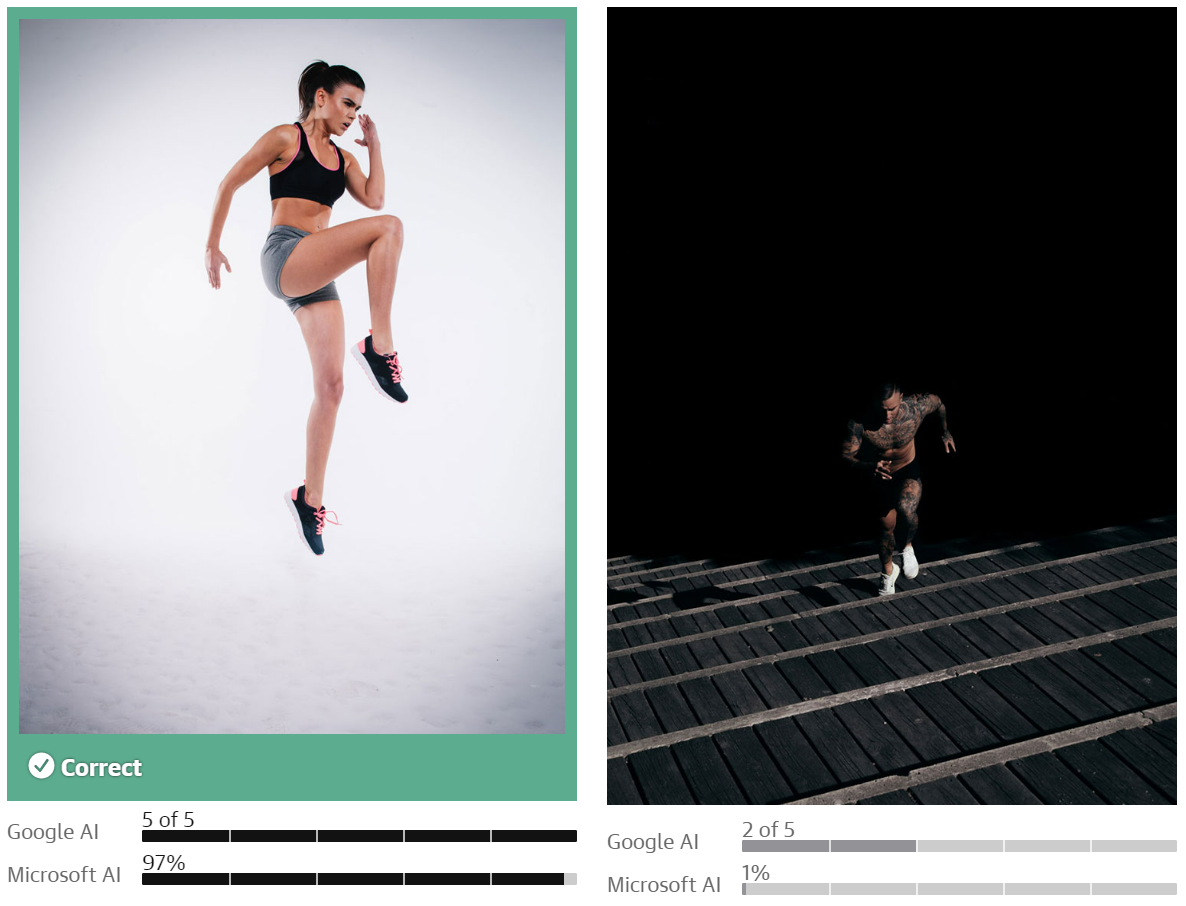

Thế nhưng mới đây, khi 2 nhà báo của hãng tin The Guardian (Anh quốc) sử dụng công cụ AI để phân tích hàng trăm bức ảnh chụp nam và nữ mặc đồ lót, tập thể dục, khám bệnh với bác sĩ, họ nhận thấy rằng, AI đã gắn thẻ cho những tấm ảnh phụ nữ đang trong các tình huống sinh hoạt hàng ngày là “khêu gợi tình dục”, "không phù hợp".

Trong khi đó, cũng với những tình huống tương tự nhưng với nhân vật nam thì lại ít bị đánh giá bằng những cụm từ tiêu cực như trên. Chính điều này đã gây hiểu lầm cho các nền tảng mạng xã hội, và vô tình một số lượng lớn hình ảnh phụ nữ lộ cơ thể bị chặn, bị xóa khi đăng lên mạng xã hội vì mục đích nghiêm túc.

|

| Google và Microsoft đều đánh giá bức ảnh có phụ nữ là "không phù hợp", trong khi bức ảnh 2 người đàn ông lại được cho là không có vấn đề gì - Ảnh: Unsplash/Guarian |

|

| Bức ảnh người phụ nữ trẻ bị AI của Google và Microsoft đánh giá là "khiêu dâm", trong khi bức ảnh người đàn ông không bị đánh giá tiêu cực - Ảnh: Unsplash/Guardian |

|

| Bức ảnh người phụ nữ đang tập thể thao này cũng bị AI của Google và Microsoft phê bình là "không phù hợp" trong khi công cụ này lại bỏ qua bức ảnh nam giới - Ảnh: Unsplash/GGuardian |

“Vấn đề này đã và đang làm tổn thương các doanh nghiệp do phụ nữ lãnh đạo, cũng như ngày càng làm trầm trọng hơn sự bất bình đẳng trong xã hội” - hãng tin The Guardian nhận định.

Ngay cả hình ảnh trong bối cảnh chăm sóc y tế cũng bị ảnh hưởng. Một bức ảnh do Viện Ung thư Quốc gia Hoa Kỳ công bố minh họa một phụ nữ đang được bác sĩ khám lâm sàng đã bị công cụ AI của Google xác định là “mang tính khiêu dâm”, còn AI của Microsoft thì cho rằng “có bản chất tình dục rõ ràng” ở mức 82%.

|

| Bức ảnh người phụ nữ được bác sĩ thăm khám cũng bị công cụ AI của Google và Microsoft gắn nhãn "khiêu dâm" - Ảnh: National Cancer Institute/Unsplash |

Tương tự, bức ảnh mô tả một phụ nữ mang thai đã bị thuật toán của Google đánh giá là "rất có khả năng chứa nội dung không phù hợp", trong khi đó, thuật toán của Microsoft khẳng định rằng hình ảnh này “có bản chất khêu gợi tình dục” ở mức 90%.

“Điều này thật đáng quan ngại” - ông Leon Derczynski, giáo sư khoa học máy tính tại Đại học CNTT Copenhagen (Đan Mạch) - bày tỏ. “Tình trạng định kiến, phân biệt đối xử với phụ nữ dường như đã ăn sâu vào cả hệ thống AI”.

|

| Bức ảnh người phụ nữ mang thai cũng bị AI hiểu lầm là "mang tính khiêu dâm" - Ảnh: Dragos Gontariu/Unsplash |

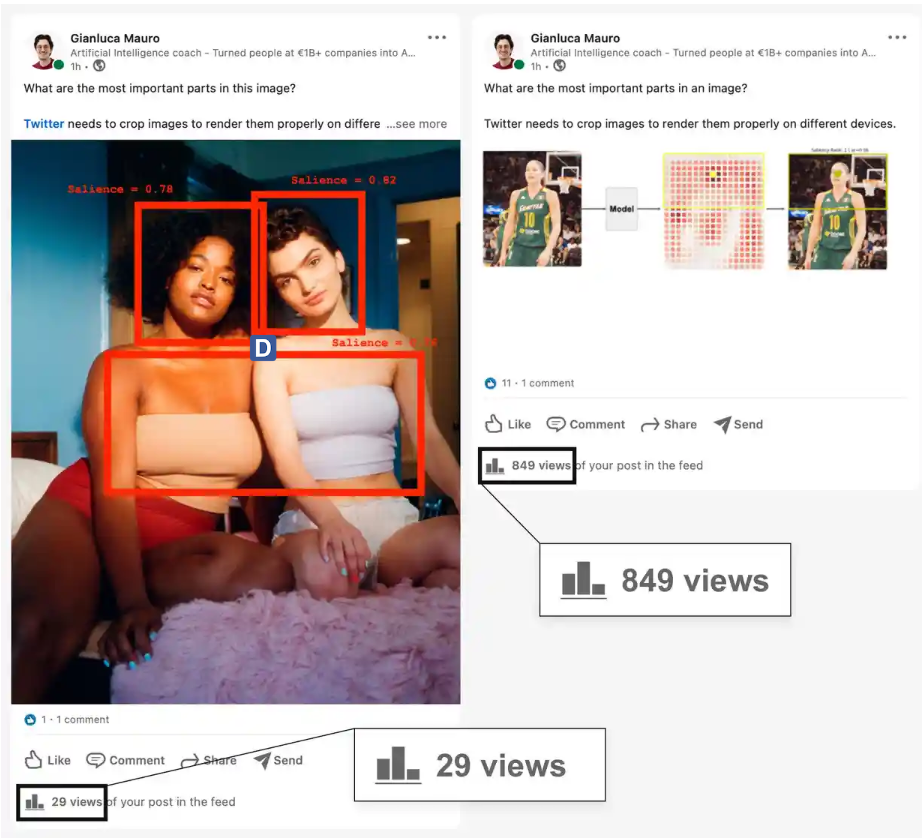

Tháng 5/2021, ông Gianluca Mauro - một doanh nhân làm việc trong lĩnh vực AI - đã đăng dòng trạng thái lên LinkedIn và ngạc nhiên khi bài viết chỉ được xem 29 lần trong 1 giờ đồng hồ (thay vì khoảng 1.000 lượt xem như các bài đăng khác).

“Có lẽ hình ảnh 2 người phụ nữ mặc áo ống chính là vấn đề khiến bài viết không được hiển thị để đông đảo người đọc tiếp cận” - ông Mauro nhận định.

Cũng nội dung bài viết đó, nhưng khi được đăng kèm hình ảnh khác trong vòng 1 giờ đồng hồ có 849 lượt xem.

|

| Hình ảnh 2 người phụ nữ ăn mặc "mát mẻ" đăng trên LinkedIn bị AI gắn nhãn "không phù hợp" và "siết" tương tác - Ảnh: Gianluca Mauro/The Guardian |

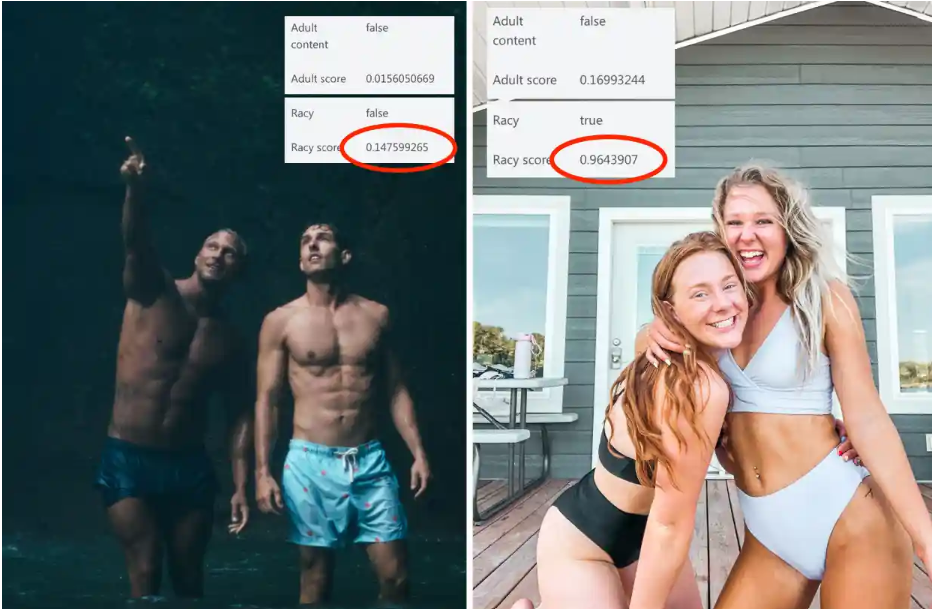

Một ví dụ khác, với 2 bức ảnh chụp phụ nữ và nam giới mặc đồ lót thể thao được đăng lên LinkedIn thì công cụ AI của Microsoft đã phân loại bức ảnh 2 phụ nữ là “không phù hợp” với điểm số lên đến 96%. Trong khi đó, với bức ảnh 2 người đàn ông, điểm đánh giá về “phân biệt chủng tộc” là rất thấp, chỉ 14%.

Ngoài ra, trong 1 giờ, bức ảnh 2 người phụ nữ chỉ có 8 lượt xem còn bức ảnh chụp 2 người đàn ông nhận được 655 lượt xem. Điều đó cho thấy, bức ảnh phụ nữ mặc đồ lót đã bị công cụ AI của Google và Microsoft chặn hoặc “siết” tương tác.

|

| Công cụ AI gắn nhãn "không phù hợp" cho bức ảnh có phụ nữ, nhưng lại bỏ qua cho bức ảnh có nhân vật nam giới - Ảnh: Gianluca Mauro/The Guardian |

Một ví dụ trực quan khác cũng cho ra kết quả tương tự. Với ảnh chụp người đàn ông để ngực trần, công cụ AI của Microsoft không xem đó là hành vi khiêu dâm (chỉ 22%). Thế nhưng khi người đàn ông mặc chiếc áo ngực vào thì ngay lập tức bức ảnh bị dán nhãn “khiêu dâm” ở mức cao đến 99%.

Tại sao AI lại định kiến với phụ nữ?

AI hiện đại được xây dựng bằng cách sử dụng phương pháp máy học (machine learning), vốn là một bộ thuật toán cho phép máy tính học hỏi từ hệ thống dữ liệu nạp vào. Khi các nhà phát triển sử dụng phương pháp máy học, họ không viết ra các quy tắc rõ ràng cho máy tính biết cách thực hiện một tác vụ mà cung cấp cho máy tính ứng dụng AI một hệ thống dữ liệu được sử dụng để huấn luyện, giúp AI phân tích hình ảnh từ những dữ liệu mà con người nạp vào, từ đó giúp nó tái tạo các quyết định để cung cấp cho con người.

Chẳng hạn như, đại đa số người dân ở một quốc gia nào đó sẽ cảm thấy khó chịu khi bắt gặp hình ảnh phụ nữ mặc đồ ngắn tập thể thao, và họ báo cáo những hình ảnh này là “không phù hợp”, “khiêu dâm”. Điều này khiến hệ thống AI tiếp nhận và áp dụng lệnh hạn chế với những bức ảnh khác có các yếu tố tương tự. Ngược lại, nam giới ở trần, mặc đồ thể thao ít vải lại không phải là vấn đề đối với nhiều người, và vì thế, cũng không là vấn đề đối với hệ thống AI.

|

| Tình trạng định kiến giới trong xã hội khiến các công cụ AI cũng bị ảnh hưởng - Ảnh: Steven Senne/AP |

“Lý tưởng nhất là các công ty công nghệ nên phân tích kỹ lưỡng xem ai đang dán nhãn dữ liệu của họ nhằm đảm bảo rằng, tập dữ liệu cuối cùng chứa đựng sự đa dạng trong quan điểm. Họ cũng nên kiểm tra xem thuật toán của mình có hoạt động tương tự trên các bức ảnh hay không, để tránh tình trạng đánh giá không công bằng” - bà Margaret Mitchell, chuyên gia đạo đức tại công ty trí tuệ nhân tạo Hugging Face (Mỹ) - khuyến cáo.

Theo phụ nữ TPHCM